Commande et Navigation Référencées Capteur -- Manipulation Mobile Interactive

Manipulation, manipulation mobile, navigation en boucle fermée sur des capteurs extéroceptifs

Considérant un robot (manipulateur, mobile, manipulateur mobile) équipé de capteurs visuels (2D, 3D), proximétriques (laser, LiDAR, RADAR), et/ou d’efforts, l’objectif est d’effectuer des tâches de positionnement, navigation ou manipulation sur la base du retour sensoriel extéroceptif. Une approche “(multi)sensor-based” permet l’exécution robuste de ces tâches en dépit de multiples contraintes ou artefacts: absence de localisation métrique ; variabilité de l’environnement ; présence d’obstacles dynamiques ; interaction physique avec l’humain ; etc. Les techniques sous-jacentes ont trait à l’asservissement visuel ou multi-capteurs, la commande prédictive, la commande coordonnée, la commande en effort, etc.

Surveillance de l’environnement d’engins de chantier

Ce projet se situe au confluent des activités en Perception Visuelle et Commande de l’équipe. L’application est la sécurisation des interactions entre des opérateurs humains et des manipulateurs mobiles lourds, qui sont sources d’accidents. Il s’agit de prédire des collisions potentielles en combinant la fusion de données capteurs (caméras fish-eye et radars embarqués) et la caractérisation de la volumétrie des engins (analyse et prédiction de l’espace de travail). Les défaillances des capteurs induites par les conditions environnementales difficiles (poussière, boue, météo) ainsi que la nature sporadique des données (occultations…) constituent des verrous importants. Les fonctions seront implémentées sur le premier calculateur français à haute performance embarqué, développé par ACTIA.

Projet France 2030 BPI PROTECH. Collaboration avec les entreprises ACTIA, AgreenCulture,... Contacts : Frédéric Lerasle et Martín Mujica.

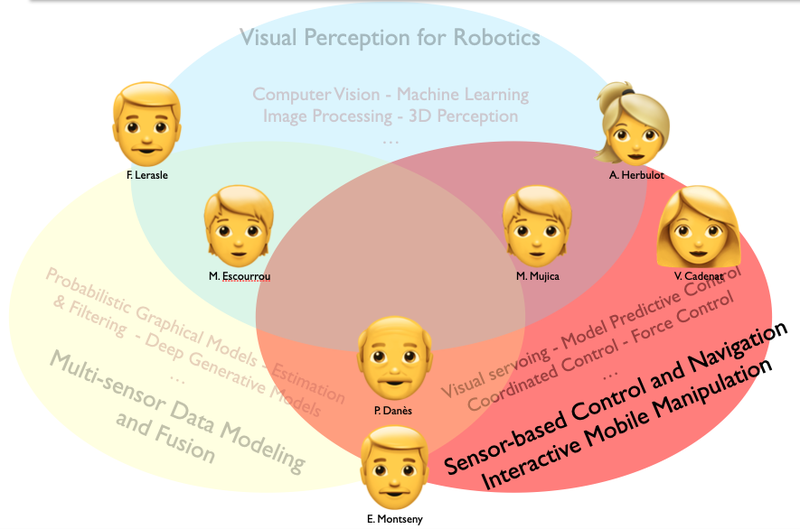

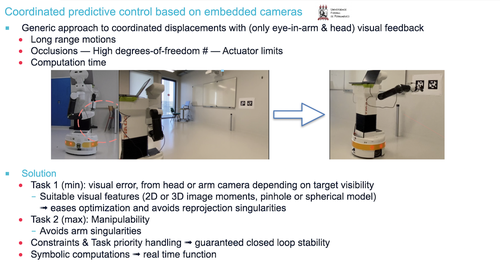

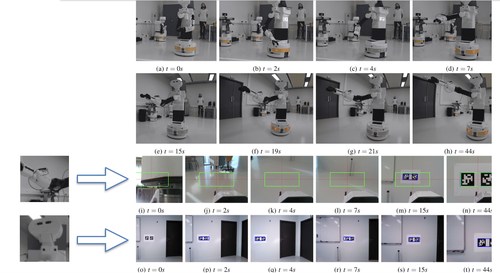

Commande coordonnée d’un robot manipulateur mobile par asservissement visuel prédictif

L’objectif est de permettre à un manipulateur mobile d’exécuter des déplacements coordonnées base+bras par feedback visuel sur les images délivrées par une caméra hand-eye et une caméra placée dans la tête. Les verrous sont : l’exploitation de la redondance ; la gestion des occultations et des saturations d’actionneurs ; l’obtention d’un algorithme implémentable en temps réel. La solution combine deux tâches priorisées en ligne de manière judicieuse : erreur, qu’il s’agit de minimiser, définie dans l’une ou l’autre des caméras sur la base d’indices visuels adéquats ; critère de manipulabilité, à maximiser. L’optimisation de la tâche hybride obtenue est effectuée dans le respect des contraintes temporelles. Une garantie théorique de stabilité en boucle fermée est obtenue dans le respect des contraintes.

Collaboration avec l’Université Fédérale de Pernanbuco, Brésil. Thèse de Doctorat d’Hugo Bildstein (Financement Université Toulouse III Paul Sabatier via l'École Doctorale EDSYS). Contact : Viviane Cadenat.

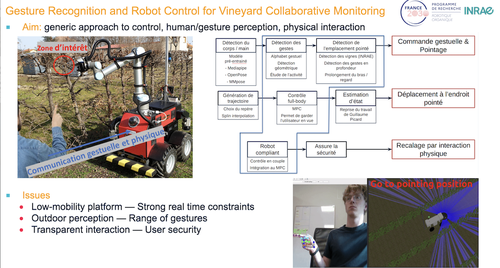

Commande d’un robot manipulateur mobile en interaction visuelle et physique avec un opérateur humain

Le cadre applicatif est la surveillance collaborative de vignoble. Le but est de définir une approche générique pour : la définition de consignes gestuelles pour un manipulateur mobile (analyse visuelle de l’opérateur humain ; détection et reconnaissance de gestes ; caractérisation d’un pointage) ; le déplacement coordonné du manipulateur mobile vers l’emplacement pointé tout en conservant le contact visuel avec l’utilisateur ; le recalage du robot par interaction physique avec l’humain, en toute sécurité. La faible mobilité de la base, la sévérité des contraintes temporelles et les conditions perceptuelles (extérieur) complexifient le problème.

Action PI2 (Manipulation Mobile Interactive) du PEPR O2R. Thèse de Doctorat de Rémi Porée (Financement O2R. Co-encadrement INRAE Clermont-Ferrand). Contact : Martín Mujica.

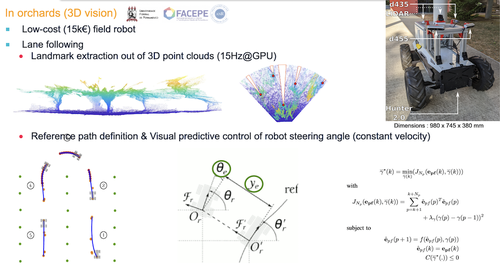

Navigation sensor-based en l’absence de localisation métrique (absolue ou relative)

La navigation d’un robot mobile dans un vignoble ou un verger est considérée, lorsqu’on ne dispose a priori que d’une information topologique sur l’environnement : rangs, allées, zones de fourrière. La navigation intra-rang exploite des primitives visuelles extraites d’images 2D ou 3D (techniques neuronales, analyse de nuages de points…) dans des algorithmes de commande gérant les occultations et les obstacles dynamiques imprévus. Le U-turn inter-rang consiste en l’exécution de trajectoires spirales définies à partir de primitives laser. Une solution toutes saisons tous temps est obtenue, qui a permis une navigation sans erreur dans un verger sur un trajet de 800m.

Collaboration avec Naio, puis Projet ANR/FACEPE ARPON avec l’Université Fédérale de Pernambuco, Brésil. Thèse de Doctorat d’Antoine Villemazet (Financement ARPON). Remerciements à la Cité des Sciences Vertes, Auzeville (31) et au CEFEL, Montauban (82). Contact : Viviane Cadenat.

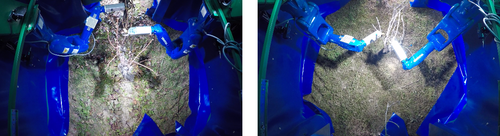

Robotique pour la Taille de Vigne

Le projet R2T2 (Robot de Taille de Vigne) avait pour objectif de concevoir et développer jusqu’au stade pré-industriel un bloc robotisé, qui, installé sur un porteur de type machine à vendanger, en prenait le contrôle pour réaliser la taille en autonomie de vignes conduites en Guyot ou Cordon de Royat. La participation de RAP à R2T2 a concerné les points suivants : contribution à l’intégration mécatronique (accessibilité et positionnement optimal des bras manipulateurs, coll. PME FLDI) ; planification de mouvements des bras manipulateurs, sans collision ni autocollision et exploitant pleinement leur dynamique ; intégration de l’ensemble des bibliothèques développées par les partenaires dans une architecture logicielle temps réel sûre de fonctionnement (incluant la communication avec le porteur, coll. entreprise CNHi) ; superviseur en charge de l’exécution concurrente et de la synchronisation des différentes fonctions (cas nominal et situations dégradées).

R2T2 était co-financé par le FUI et la Région Occitanie (2018-2021+). Outre le LAAS-CNRS, il impliquait la Coopérative Vinovalie (porteur), l’Institut Français de la Vigne et du Vin, l’ICAM Toulouse, les PMEs ORME et FLDI, ainsi que CNHi. Remerciements au Pôle Agri Sud-Ouest Innovation pour son soutien, ainsi qu’aux équipes GEPETTO et RIS dont les technologies, concrétisées par des suites logicielles open-source, ont également été intégrées dans le projet. Contact : Patrick Danès.

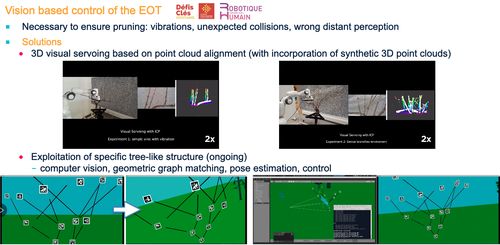

Consécutivement à R2T2, la commande référencée vision de l’organe de coupe d’un robot de taille de vigne est étudiée, selon deux lignes de recherche : combinaison de techniques d’alignement de nuages de points de type ICP (iterative closest point) et d’asservissement 3D (avec incorporation de consignes synthétisées par simulation) ; exploitation de structures spécifiques aux végétaux arborescents tels que la vigne.

Thèse de Doctorat de Fadi Gebrayel (Financement conjoint Défi-Clé Robotique Centrée sur l’Humain (La Région Occitanie, via l'Université de Toulouse) et LAAS-CNRS/RAP). Contacts : Martín Mujica, Patrick Danès.

Un projet Concert Japan est en cours d’évaluation, impliquant des partenaires français, allemand, et japonais.