Publication trimestrielle du Laboratoire

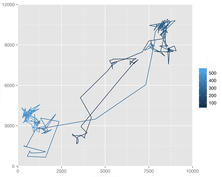

d'analyse et d'architecture des systèmes du CNRS

Dans le cadre de la robotique d'assistance, cette thèse a pour but defusionner deux canaux d'informations (visuelles et auditives) dont peutdisposer un robot afin de compléter et/ou confirmer les données qu'un seulcanal aurait pu fournir, et ce, en vue d'une interaction avancée entrehomme et robot. Pour ce faire, nos travaux proposent une interfaceperceptuelle pour l'interaction multimodale ayant vocation à interpréterconjointement parole et geste, notamment pour le traitement des référencesspatiales.Nous décrivons dans un premier temps la composante parole de nos travauxqui consiste en un système embarqué de reconnaissance et d'interprétationde la parole continue. Nous détaillons ensuite la partie vision composéed'un traqueur visuel multi-cibles chargé du suivi en 3D de la tête et desdeux mains, ainsi que d'un second traqueur chargé du suivi del'orientation du visage. Ces derniers alimentent un système dereconnaissance de gestes par DBNs. Nous poursuivons par la descriptiond'un module chargé de la fusion des données issues de ces sourcesd'informations dans un cadre probabiliste. Enfin, nous démontronsl'intérêt et la faisabilité d'une telle interface multimodale à travers uncertains nombre de démonstrations sur les robots du LAAS-CNRS. L'ensemblede ces travaux est fonctionnel sur ces plateformes robotiques réelles.